Множение энтропии является одним из ключевых понятий в области информационной теории. Это понятие позволяет нам определить объем информации, содержащейся в системе или процессе. В основе этой концепции лежит представление информации как меры неопределенности или случайности.

Энтропия является основной характеристикой неопределенности в системе. Чем выше энтропия, тем больше неопределенности содержится в данной системе. Множение энтропии представляет собой операцию, с помощью которой мы можем определить, как энтропия одной системы влияет на энтропию другой системы взаимодействующей с ней.

Одной из основных особенностей множения энтропий является то, что процесс взаимодействия двух систем может как увеличить, так и уменьшить общую энтропию системы. Такое поведение можно объяснить тем, что в процессе взаимодействия между системами происходит обмен информацией, что в свою очередь влияет на степень неопределенности в обеих системах.

Множение энтропии является важным инструментом для оценки информационной сложности системы и позволяет увидеть взаимозависимость между различными системами. Понимание данного понятия поможет нам лучше осознать и оценить структуру и природу информации в различных областях науки и техники.

Роль энтропии в физике

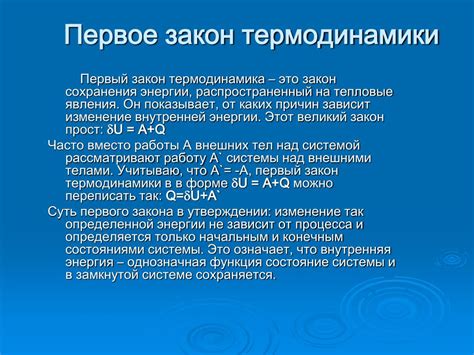

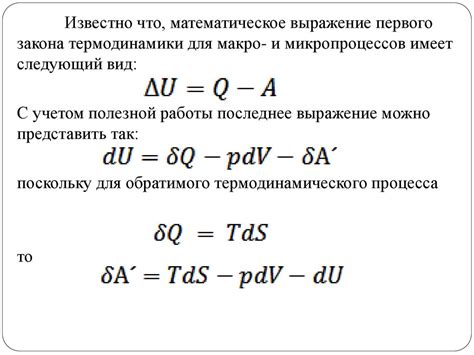

Первый закон термодинамики, также известный как закон сохранения энергии, утверждает, что энергия в системе остается постоянной. Однако он не описывает направление, в котором энергия может перемещаться. Вот где вступает в игру второй закон термодинамики, утверждающий, что энтропия в изолированной системе всегда увеличивается или остается неизменной.

Это означает, что процессы, происходящие в системе, всегда стремятся к повышению беспорядка. Например, если вы наливаете горячий кофе в чашку со льдом, тепло от кофе будет передаваться к льду, пока температуры не выровняются. В результате получится комнатная температура, где все частицы имеют примерно одинаковую энергию. В этом процессе энтропия системы - кофе и льда - увеличивается.

Второй закон термодинамики и понятие энтропии имеют огромное значение для физики и позволяют объяснить множество явлений в мире. Они помогают понять, почему процессы в природе происходят в определенном направлении и почему некоторые явления невозможны или крайне маловероятны.

Таким образом, понимание роли энтропии в физике позволяет лучше понять физические процессы, происходящие в нашем мире и разработать эффективные способы управлять ими.

Определение энтропии

Формально, энтропия определяется как средняя информация, необходимая для определения значения случайной величины. Чем больше энтропия, тем больше неопределенность. Если случайная величина имеет только одно возможное значение, то энтропия будет равна нулю.

| Количество возможных значений | Энтропия (в битах) |

|---|---|

| 2 | 1 |

| 4 | 2 |

| 8 | 3 |

| 16 | 4 |

| ... | ... |

Энтропия также может быть использована для оценки сложности системы или информационного источника. Чем выше энтропия, тем более сложной считается система или источник информации. В термодинамике, энтропия также измеряет степень хаоса или неопределенности в системе.

Понимание и использование энтропии является фундаментальным в различных областях, таких как компьютерные науки, информационная безопасность и статистика.

Основные принципы термодинамики

Первый принцип термодинамики гласит, что энергия в замкнутой системе сохраняется. Она может переходить из одной формы в другую, но ее общая сумма остается постоянной. Это принцип является основой для понимания работы и теплоты, которые являются формами энергии.

Второй принцип термодинамики устанавливает, что энтропия замкнутой системы всегда увеличивается или остается неизменной. Энтропия - это мера хаоса или беспорядка в системе. Увеличение энтропии разрешено, а уменьшение - запрещено. Этот принцип объясняет направление физических процессов, например, почему горячие предметы остывают и почему беспорядок в природе увеличивается.

Третий принцип термодинамики устанавливает, что при достижении абсолютного нуля температуры, все вещества достигают своего минимального энергетического состояния. Это означает, что при абсолютном нуле все молекулы перестают двигаться и система достигает максимально упорядоченного состояния. Этот принцип не может быть достигнут на практике, но он служит важным ориентиром в понимании поведения веществ при низких температурах.

Связь энтропии с вероятностью

Связь энтропии с вероятностью можно выразить следующей формулой:

| Вероятность | Энтропия |

|---|---|

| 0 | 0 |

| 1 | 0 |

| p | -p * log2(p) |

Если вероятность события равна 0 или 1, то энтропия такого события будет равна 0, так как информация о нем уже известна или невозможна. Если вероятность события равна p, то энтропия данного события будет максимальной и равна -p * log2(p). Чем ближе вероятность к 0 или 1, тем меньше энтропия, так как информация становится более предсказуемой.

Связь энтропии с вероятностью является важным понятием в теории информации. Она позволяет оценить количество информации, содержащейся в случайной величине, и является основой для множества математических моделей и алгоритмов, используемых в обработке и передаче информации.

Понятие множения энтропии

Энтропия - это мера неопределенности случайной переменной. Чем больше энтропия, тем более неопределенная переменная.

Множение энтропии применяется в случаях, когда две или более случайные переменные взаимозависимы. Оно позволяет нам определить, сколько информации мы можем получить, знаю только одну из переменных.

Математически, множение энтропии определяется как произведение энтропий двух случайных переменных. Если H(X) и H(Y) - энтропии двух случайных переменных X и Y соответственно, то множение энтропии обозначается H(X,Y) и равно H(X,Y) = H(X) * H(Y).

Применение множения энтропии имеет широкие применения в обработке информации, например, в криптографии и кодировании информации. Оно помогает определить оптимальное кодирование данных, учитывая их взаимосвязь.

Таким образом, множение энтропии является важным инструментом для измерения и анализа возможностей передачи и кодирования информации, основываясь на взаимосвязи случайных переменных.

Примеры применения множения энтропии

Одним из примеров применения множения энтропии является криптография. В криптографии энтропия может использоваться для оценки безопасности шифра. Если множение энтропии максимально, то это говорит о большой сложности взлома шифра. В этом случае шифр считается сильным и надежным.

Еще одним примером является обработка изображений. Множение энтропии может быть полезным в задачах сегментации изображений или выделения объектов. Путем вычисления энтропии можно определить области изображения с высокой степенью неопределенности. Это может использоваться при автоматической обработке фотографий или в компьютерном зрении.

Другим примером использования множения энтропии является анализ текстов. Энтропия может использоваться для измерения степени разнообразия слов или символов в тексте. Например, в машинном обучении энтропия может быть использована для классификации текстов на основе их уникальности и структуры.

Множение энтропии также может применяться в области сетей и передачи данных. Оно может быть использовано для измерения степени сжатия данных или эффективности алгоритмов сжатия. Более энтропийный набор данных требует меньше сжатия и может указывать на наличие повторяющихся или предсказуемых шаблонов.