Байт - это минимальная единица измерения информации в компьютерах, которая состоит из 8 бит. У каждого символа есть свое уникальное представление в виде кода. В ранние годы развития компьютеров использовалась различная кодировка символов, и не каждая из них использовала 1 байт для представления каждого символа.

Однако, с развитием технологий и использованием стандартизированных кодировок, таких как ASCII и UTF-8, каждому символу было назначено уникальное число, и они начали быть представлены одним байтом. То есть, каждый символ занимает ровно 8 бит в компьютерной памяти.

Это имеет свои преимущества. Во-первых, использование 1 байта для представления каждого символа позволяет существенно упростить работу с текстом, так как теперь каждый символ может быть легко представлен и храниться в памяти компьютера. Во-вторых, такая стандартизация позволяет обмениваться информацией между различными компьютерами и программами, не волнуясь о том, что символы будут некорректно отображаться или передаваться.

Конечно, однобайтовая кодировка имеет свои ограничения. Например, она не может представлять символы, не входящие в стандартную таблицу символов, а также может ограничивать использование специфичных символов в определенных языках.

В целом, представление каждого символа одним байтом является стандартом в современных компьютерных системах и существенно упрощает работу с текстом и обмен информацией между различными устройствами и программами.

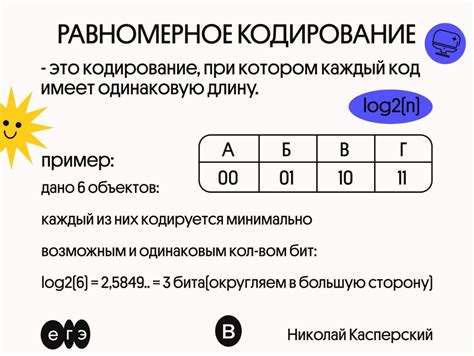

Что значит "кодирование"?

Одна из распространенных форм кодирования – кодирование символов в байты. Байт – это основная единица измерения информации в компьютерах, равная 8 битам. Если каждый символ кодируется 1 байтом, то это означает, что каждому символу сопоставляется 8-битное число. Такая система кодирования позволяет представлять большое количество различных символов, включая буквы, цифры, знаки пунктуации и специальные символы.

Примером такой кодировки является ASCII (American Standard Code for Information Interchange), который был широко использован в прошлом. В настоящее время часто используется расширенный формат UTF-8 (Unicode Transformation Format), который поддерживает большое количество символов различных письменностей и языков.

Кодирование символов в байты имеет ряд преимуществ, таких как универсальность, эффективное использование памяти и простота обработки данных. Однако, при работе с кодировками необходимо быть внимательным, чтобы не возникало проблем с правильным отображением символов и интерпретацией данных.

В общем понимании, кодирование – это процесс превращения информации в определенный формат, который может быть использован для хранения, передачи или обработки. Оно играет важную роль в области информационных технологий и является неотъемлемой частью работы с данными.

Как символы кодируются?

Когда говорят о том, что каждый символ кодируется 1 байтом, это означает, что каждому символу присваивается числовое значение, которое затем записывается в памяти компьютера. Как именно происходит данный процесс кодирования символов?

Для кодирования символов широко используется таблица символов, такая как Unicode или ASCII. Таблица символов - это набор символов и их соответствующих числовых значений, называемых кодовыми точками.

В таблице символов Unicode каждому символу присваивается уникальный код, известный как кодовая точка. Кодовая точка может быть представлена целым числом в десятичной или шестнадцатеричной системе счисления. Например, кодовая точка символа "A" равна 65 в десятичной системе или 41 в шестнадцатеричной системе.

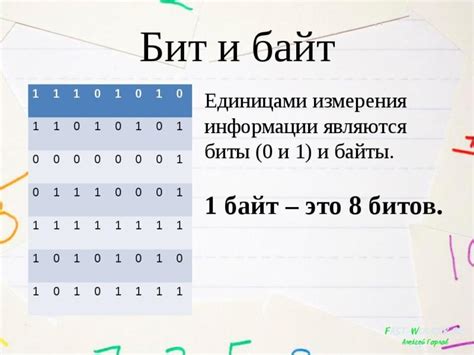

Для записи кодовых точек в памяти компьютера используется бинарный формат, представленный в виде последовательности битов - единиц и нулей. Каждая кодовая точка может быть представлена с помощью фиксированного количества битов, и используется определенное количество битов для представления каждого символа. В случае кодировки, где каждый символ кодируется 1 байтом, это означает, что для представления каждого символа используется 8 битов.

При чтении символа из памяти компьютера, его кодовая точка сопоставляется с символом в таблице символов, и мы получаем конечный символ, который можно отобразить на экране или использовать в других операциях с данными.

Использование кодирования символов, где каждый символ кодируется 1 байтом, имеет свои преимущества и недостатки. Одним из преимуществ является то, что это простая и эффективная система, где каждый символ имеет фиксированное представление в памяти компьютера. Однако, такая кодировка может быть недостаточно гибкой для работы с большим количеством символов, которые не попадают в пределы 8-битного представления.

Все вместе, кодирование символов - это сложная и важная концепция, о которой каждый программист должен знать, чтобы корректно работать с текстом и символами в своих программах.

Что такое байт?

Байты широко используются в компьютерных программировании для представления символов, чисел и других типов данных. Например, каждый символ в текстовых файлах представлен одним или несколькими байтами, в зависимости от используемой кодировки.

Также байты используются для передачи данных по сети. В сетевых протоколах данные часто разбиваются на байты и передаются от отправителя к получателю. Компьютеры и другие устройства могут обмениваться информацией, используя байты в качестве единицы измерения.

Кодирование каждого символа одним байтом означает, что для представления каждого символа используется ровно 8 битов. Это стандартный подход, который позволяет представить широкий набор символов и значений с помощью ограниченного числа битов.

Значение 1 байта для кодирования символов

В современных компьютерах и коммуникационных сетях информация обычно представляется в виде последовательности байтов. Каждый байт состоит из 8 битов, что позволяет представить 256 различных значений (от 0 до 255).

Когда говорят о кодировании символов, 1 байт обычно используется для представления каждого символа. Это означает, что каждому символу присваивается уникальный числовой код, который затем представляется в виде 1 байта.

Система кодирования символов, которая использует 1 байт для представления каждого символа, называется однобайтовой кодировкой. Однобайтовые кодировки широко используются в различных компьютерных системах для представления текста на разных языках, включая английский, русский, немецкий и многие другие языки.

Однако стоит отметить, что однобайтовая кодировка ограничивает количество символов, которые могут быть представлены, до 256. Это означает, что однобайтовая кодировка может быть недостаточной для представления всех символов, используемых в некоторых языках, таких как китайский, японский или кириллица, где количество символов превышает 256.

В целом, значение 1 байта для кодирования символов заключается в простоте и эффективности представления текста на многих языках. Однобайтовые кодировки продолжают широко использоваться во многих компьютерных системах, хотя для поддержки более широкого набора символов могут быть использованы много-байтовые кодировки.