Лексический разбор - это первый этап в обработке текстовых данных, который заключается в разделении исходного текста на последовательность лексем или токенов. Лексема представляет собой минимальную смысловую единицу в языке программирования или естественном языке.

Процесс выполнения лексического разбора имеет важное значение для дальнейшей обработки текста. Он позволяет привести сложный и неформатированный текст к структурированному виду, что erleichtert boca последующих шагов обработки рассматриваемой информации. Более того, лексический разбор позволяет распознавать ключевые слова и конструкции языка в соответствии с грамматикой и правилами, что существенно упрощает задачу дальнейшего анализа семантики предложенного текста.

В процессе лексического разбора важно определить, какие лексемы встречаются и в какой последовательности они расположены в тексте. Эта информация пригодится в последующих этапах обработки, таких как синтаксический анализ и разрешение семантических зависимостей.

На практике лексический разбор реализуется с помощью специальных алгоритмов и инструментов, таких как лексические анализаторы и сканеры. Они основаны на формальной грамматике и правилах, которые задают синтаксис исходного языка или формата данных. Лексический анализ помогает выделить из текста числа, строки, ключевые слова и другие лексемы, а также провести их классификацию и дополнительные преобразования для дальнейшего анализа и использования.

Важно отметить, что лексический разбор применяется не только в области программирования, но и в других сферах, где необходимо обрабатывать и структурировать текстовые данные. Например, в компьютерной лингвистике, информационном поиске, анализе естественного языка и многих других областях.

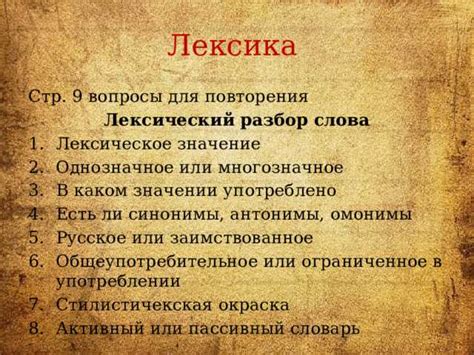

Лексический разбор: определение и основные принципы выполнения

Цель лексического разбора заключается в преобразовании входной строки символов в последовательность лексем, которые могут быть легко обработаны и проанализированы другими частями компилятора или интерпретатора.

Основные принципы выполнения лексического разбора включают следующие шаги:

- Сканирование: происходит чтение входной строки символов и анализ каждого символа для определения его типа, например, цифра, буква или специальный символ.

- Распознавание: на основе типа символа определяется лексема, к которой он относится. Например, если символ является буквой, он может быть идентификатором или ключевым словом.

- Группировка: лексемы объединяются в логические группы, такие как операторы, переменные или числа.

- Генерация: после группировки лексемы передаются следующему этапу компиляции или интерпретации для дальнейшего анализа.

Лексический разбор является первым шагом в обработке исходного кода программы и является важной частью компиляторов, интерпретаторов и других инструментов разработки программного обеспечения. Правильное выполнение лексического разбора позволяет обнаруживать и исправлять ошибки в исходном коде, а также эффективно анализировать и интерпретировать программы.

Лексический анализ: что это и для чего нужно

Основная цель лексического анализа заключается в представлении исходного кода в удобной форме для последующей обработки. Часто лексический анализатор преобразует исходный код в последовательность токенов, которые затем передаются на следующий этап разбора - синтаксический анализ.

Кроме того, лексический анализ используется для обнаружения и обработки ошибок в исходном коде. Например, анализатор может выдавать сообщения об ошибках, если обнаружены некорректные лексемы или недопустимые комбинации символов.

Лексический анализ также играет важную роль при создании компиляторов и интерпретаторов. Каждый компилятор или интерпретатор включает лексический анализатор, который предварительно обрабатывает исходный код, разбивая его на отдельные лексемы. Затем синтаксический анализатор может использовать последовательность токенов для создания синтаксического дерева или выполнять другие операции в зависимости от целей конкретного проекта.

Таким образом, лексический анализ не только упрощает последующую обработку исходного кода, но и является неотъемлемой частью процесса создания и исполнения программного обеспечения.

Этапы лексического разбора

Лексический анализатор проходит через несколько этапов, каждый из которых выполняет определенные операции:

- Считывание символов. В этом этапе лексический анализатор последовательно считывает символы из исходного текста.

- Обработка пробелов и комментариев. Белые пробелы и комментарии обычно не являются значимыми для лексического анализа и поэтому удаляются или игнорируются.

- Разделение на лексемы. В этом этапе анализатор разделяет исходный текст на лексемы, используя определенные правила, называемые регулярными выражениями. Лексемы могут быть идентификаторами, операторами, константами и другими элементами языка.

- Создание токенов. На этом этапе каждая лексема преобразуется в токен – структуру данных, содержащую информацию о типе лексемы и ее значении.

Выполнение лексического разбора является необходимым шагом при компиляции программы или обработке языка разметки. Лексический анализатор позволяет преобразовать исходный текст в удобный для дальнейшего анализа формат и обнаружить ошибки синтаксиса или орфографические ошибки.

Токенизация: первый шаг лексического анализа

Токены представляют собой минимальные значимые элементы текста, такие как слова, числа, знаки препинания и другие разделители. Каждый токен имеет свою лексическую или семантическую роль в тексте и может быть использован для дальнейшего анализа и обработки.

Процесс токенизации выполняется с использованием специальных правил или шаблонов, которые определяют, какие символы или последовательности символов будут считаться токенами. Например, в английском тексте пробелы обычно используются в качестве разделителей между словами, а знаки препинания, такие как точки и запятые, могут быть отдельными токенами.

Токенизация имеет множество практических применений. Например, в обработке естественного языка токенизация является важным этапом при выполнении анализа тональности текста, машинного перевода, извлечения ключевых слов и других задач. Также, токенизация может использоваться для выполнения поиска и фильтрации текстовых данных в базах данных и поисковых системах.

Важно отметить, что правила токенизации могут быть зависимыми от контекста и языка текста. Например, слова в русском языке часто имеют разные формы, в зависимости от их роли в предложении. Токенизация должна учитывать эти особенности языка, чтобы правильно разделить текст на токены.

В итоге, токенизация является важным этапом для последующего анализа текста. Токены могут быть использованы для выделения значимых элементов текста, их классификации, фильтрации или агрегации для дальнейшей обработки и анализа данных.

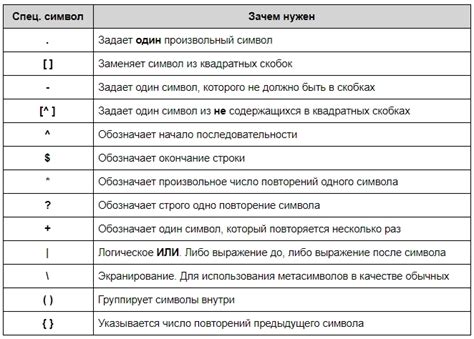

Регулярные выражения: основной инструмент для лексического разбора

Регулярные выражения - это шаблоны поиска и сопоставления строковых данных. Они позволяют указать определенные правила для поиска, фильтрации и извлечения нужной информации из текста. Регулярные выражения мощны и гибки, они позволяют задать сложные условия, использовать операции над строками и символами.

В контексте лексического разбора регулярные выражения используются для определения структуры и синтаксиса языка или формата данных. Они позволяют задать правила для определения лексических единиц, таких как числа, строки, операторы и ключевые слова. Эти правила затем используются для последовательного сканирования и идентификации лексем в тексте.

Преимущества регулярных выражений в лексическом разборе заключаются в их высокой производительности и удобстве использования. Они позволяют точно задать нужные шаблоны и операции, и эффективно справляются с обработкой текста различных форматов и сложности. Благодаря своей широкой поддержке и интеграции в различные языки программирования, регулярные выражения являются основным инструментом для лексического разбора.

Преобразование токенов в абстрактное дерево разбора

Процесс преобразования токенов в АДР включает в себя построение синтаксических правил, соответствующих грамматике языка программирования. Эти правила определяют структуру языка и описывают, какие комбинации токенов являются валидными и как они связаны друг с другом.

Для построения АДР используются различные алгоритмы, такие как рекурсивный спуск, LL(1), LR(1) и т.д. Каждый алгоритм имеет свои преимущества и ограничения, и выбор подходящего зависит от особенностей языка программирования и требований проекта.

Преобразование токенов в АДР позволяет разбить исходный код программы на характерные единицы, такие как выражения, операторы, функции и т.д. Каждая единица представлена узлом в АДР, который содержит информацию о соответствующей токену и его родителе.

АДР может использоваться для дальнейшего анализа и обработки программы. Например, на основе АДР можно построить дерево разбора, которое позволяет выполнять дополнительные проверки на корректность исходного кода, такие как проверка типов, обнаружение ошибок и т.д. Также АДР может быть использовано для генерации промежуточного представления программы или выполнения оптимизаций.