SVM (support vector machine) — это алгоритм машинного обучения, который используется для классификации и регрессии. Он основан на идее разделения данных при помощи гиперплоскостей в многомерном пространстве.

Основная задача SVM — найти гиперплоскость, которая максимально разделит классы данных. Это означает, что SVM стремится найти такую гиперплоскость, которая будет максимально удалена от ближайших к ней точек каждого класса.

Принцип работы SVM можно представить так:

1. Сначала алгоритм SVM преобразует данные векторами в многомерном пространстве. Эти векторы называются опорными векторами.

2. Затем SVM ищет гиперплоскость, которая разделяет опорные векторы разных классов как можно дальше друг от друга.

3. После этого SVM классифицирует новые данные, определяя, по какую сторону от гиперплоскости они находятся.

SVM — это алгоритм, который широко применяется в различных областях, таких как распознавание образов, текстовая классификация, анализ тональности и другие задачи машинного обучения.

Что такое SVM и зачем он нужен

Основная задача SVM – найти такую гиперплоскость, которая бы максимально разделила обучающие данные разных классов и минимизировала число ошибок классификации. Для этого метод использует опорные векторы – точки обучающей выборки, находящиеся ближе всего к разделяющей гиперплоскости.

Преимущества SVM включают в себя:

- Эффективность в задачах классификации с большим количеством признаков;

- Способность работать с различными типами данных, включая текстовую информацию;

- Устойчивость к выбросам в данных;

- Малая зависимость от размера обучающей выборки;

- Способность решать задачи с нелинейными разделяющими гиперплоскостями с помощью ядерных функций.

С помощью SVM можно решать широкий спектр задач, таких как обнаружение спама, категоризация текстов, классификация изображений, прогнозирование финансовых временных рядов и др. На практике SVM широко применяется в различных областях, включая медицину, биологию, финансы и многие другие.

Основные принципы работы SVM

Ключевой принцип работы SVM заключается в нахождении оптимального разделительного гиперплоскости, которая максимально отделяет данные двух классов. Гиперплоскость является N-1-мерным аффинным подпространством в N-мерном пространстве данных.

Алгоритм SVM стремится найти такую разделяющую гиперплоскость, которая максимизирует расстояние (зазор) между двумя классами. Из-за этого SVM получил своё название – метод опорных векторов. Опорные векторы – это точки данных, которые лежат на границе двух классов и определяют положение разделяющей гиперплоскости.

Для обучения модели SVM используется обучающая выборка, состоящая из примеров разных классов. Алгоритм находит гиперплоскость, которая максимально отделяет точки двух классов, и строит классификационную модель. Затем, при классификации новых данных, модель SVM определяет, по какую сторону от разделяющей гиперплоскости находится каждая точка, и присваивает ей соответствующий класс.

Важно отметить, что SVM является линейным классификатором, то есть работает только с линейно разделимыми данными. Однако, для работы с нелинейными данными можно применить трюк ядра, который позволяет преобразовывать данные в более высокую размерность и строить нелинейные разделяющие гиперплоскости.

Алгоритм обучения SVM

Алгоритм обучения SVM включает в себя следующие шаги:

| Шаг 1: | Представление данных. Первоначально данные должны быть представлены в виде числовых признаков, каждый из которых описывает объекты в многомерном пространстве. |

| Шаг 2: | Выбор ядра. Ядро определяет способ преобразования данных для создания разделяющей гиперплоскости. Ядро может быть линейным, полиномиальным, радиальным базисным функциональным (RBF) и др. |

| Шаг 3: | Определение оптимальной разделяющей гиперплоскости. Алгоритм SVM стремится найти гиперплоскость, которая максимально разделяет объекты разных классов и находится на наибольшем расстоянии от этих объектов. Чаще всего используется метод опорных векторов. |

| Шаг 4: | Обучение модели. В этом шаге происходит тренировка модели с помощью подбора оптимальных значений коэффициентов разделяющей гиперплоскости на основе представленных данных. |

| Шаг 5: | Тестирование и оценка модели. После обучения модель проверяется на тестовом наборе данных для оценки ее точности и надежности. |

Алгоритм обучения SVM имеет ряд преимуществ, включая эффективность в работе с большими наборами данных, хорошую обобщающую способность и возможность использования различных ядер для адаптации к разным типам данных.

Терминология связанная с SVM

Для понимания и работы с SVM нужно быть знакомым с некоторыми терминами:

- Объекты - это данные или примеры, которые SVM использует для обучения и классификации. Обычно объекты представлены в виде векторов признаков.

- Признаки - это характеристики, которые описывают объекты. Признаки могут быть числовыми, категориальными или бинарными. Например, при классификации писем на "спам" и "не спам", признаками могут быть количество вхождений определенных слов или наличие в письме определенных фраз.

- Разделяющая гиперплоскость - это гиперплоскость в пространстве признаков, которая разделяет объекты разных классов. SVM стремится найти оптимальную разделяющую гиперплоскость, максимально удаленную от ближайших объектов разных классов.

- Опорные векторы - это объекты, которые лежат на оптимальной разделяющей гиперплоскости или на некотором малом расстоянии от нее. Опорные векторы играют важную роль в SVM, так как они определяют положение разделяющей гиперплоскости.

- Случайные величины - это величины, которые определяют положение и форму разделяющей гиперплоскости. Они вычисляются в процессе обучения SVM.

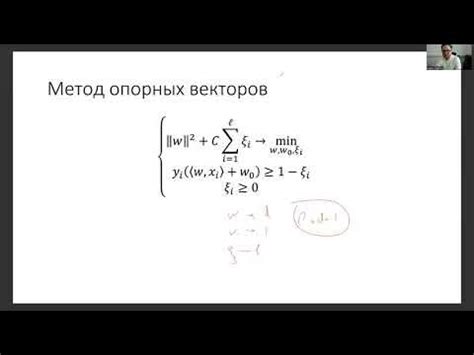

- Оптимизационная задача - это задача, которую SVM решает для нахождения оптимальной разделяющей гиперплоскости. Оптимизационная задача может быть сформулирована как задача минимизации функции потерь с некоторыми ограничениями.

Ядро (Kernel)

Ядро (Kernel) в методе опорных векторов (SVM) представляет собой функцию, которая используется для преобразования данных в пространство более высокой размерности. Это позволяет SVM классифицировать данные, которые иначе не могли бы быть линейно разделимыми в исходном пространстве.

Ядро является ключевым компонентом SVM, так как оно определяет, как данные будут преобразовываться и как будет строиться гиперплоскость для разделения классов. Наличие различных типов ядер позволяет модели SVM решать различные задачи и работать с разными типами данных.

Основная идея ядра заключается в том, что преобразование данных может создать новые особенности, которые позволяют лучше разделять объекты разных классов. Ядро может применять различные функции, такие как полиномиальные функции, радиально-базисные функции Гаусса (RBF) и сигмоидные функции. Каждое из этих ядер имеет свои уникальные свойства и применимо для разных типов данных.

Свободный член (Bias)

Свободный член позволяет более гибко управлять моделью SVM. Он позволяет сместить гиперплоскость так, чтобы учесть различные факторы в данных, которые не могут быть линейно разделены.

Путем изменения значения свободного члена можно контролировать компромисс между точностью классификации и шириной разделяющей полосы. Значение свободного члена будет влиять на положение гиперплоскости относительно данных и, следовательно, на результаты классификации.

В общем случае, свободный член позволяет модели SVM учитывать сложные взаимодействия и шум в данных, что делает его более гибким и способным к обработке нелинейных задач классификации.

Преимущества и недостатки SVM

Преимущества:

- SVM обладает высокой точностью при обучении модели и предсказании на новых данных.

- Он способен обрабатывать данные высокой размерности и встроен в различные пакеты машинного обучения.

- Работает хорошо на данных с нелинейными отношениями.

- Использование функции ядра позволяет обрабатывать данные, которые не являются линейно разделимыми.

- SVM применим в различных областях, включая классификацию, регрессию и обнаружение выбросов.

Недостатки:

- При работе с большими объемами данных и большим количеством признаков SVM может быть времязатратным.

- Выбор оптимальных параметров ядра и ширины полосы для разделения может быть сложным и требовать больших вычислительных ресурсов.

- Также, SVM может быть чувствителен к шуму и выбросам в данных.

- Не позволяет предсказывать вероятности классов непосредственно, требует использования дополнительных методов.

Преимущества

1. Эффективность: SVM показывает высокую эффективность при работе с большими объемами данных. Алгоритм работает быстрее на больших наборах данных, так как он использует лишь небольшое количество опорных векторов для классификации.

2. Устойчивость к выбросам: SVM способен обрабатывать выбросы и шум в данных. Алгоритм стремится найти границу разделения, которая максимально удалена от всех точек данных, что делает его независимым от выбросов.

3. Мощность: SVM способен работать с разнообразными типами данных и может использоваться для решения задач классификации, регрессии и даже обнаружения аномалий.

4. Способность управлять сложными разделяющими границами: SVM может использовать разные ядра, такие как линейное, полиномиальное или радиальное базисное, чтобы создавать сложные и составные границы разделения классов. Это позволяет алгоритму эффективно работать с сложными и нелинейными данных.

Недостатки

1. Вычислительная сложность: SVM может столкнуться с проблемами вычислительной сложности при обработке больших наборов данных. Обучение модели может занять много времени и требовать больших вычислительных ресурсов.

2. Чувствительность к выбросам: SVM может быть чувствителен к выбросам в данных. Даже небольшие изменения в выборке данных могут привести к значительным изменениям в разделяющей гиперплоскости.

3. Неэффективность для многоклассовой классификации: Изначально SVM разработан для бинарной классификации, и его применение к многоклассовой классификации может потребовать дополнительных алгоритмов, таких как One-vs-Rest или One-vs-One, что может затруднить и усложнить процесс.

4. Требование к предварительной обработке данных: SVM требует предварительной обработки данных, такой как масштабирование и нормализация, чтобы обеспечить лучшее качество модели. Это может потребовать дополнительных вычислительных ресурсов и времени.

5. Ограниченность в работе с нечисловыми данными: SVM обычно работает только с числовыми данными. В случае, если данные содержат категориальные переменные или текстовые данные, требуется их дополнительная обработка, например, преобразование в числовые признаки или использование метода опорных векторов для текста.

Практические примеры использования SVM

Алгоритм SVM успешно применяется во многих областях и имеет широкий спектр применений. Вот некоторые практические примеры:

- Бинарная классификация: SVM может использоваться для разделения двух классов данных. Например, он может быть использован для распознавания спама в электронной почте, где целью является отделение спам-сообщений от нормальной почты.

- Многоклассовая классификация: SVM может быть расширен для решения задач классификации с более чем двумя классами. Например, его можно использовать для классификации изображений на несколько категорий, таких как, собаки, кошки, автомобили и т.д.

- Регрессионный анализ: SVM также может быть применен для решения задач регрессии. Например, его можно использовать для прогнозирования стоимости недвижимости на основе различных признаков, таких как, площадь, количество комнат и т.д.

- Анализ текста: SVM может быть использован для анализа текстовых данных, таких как, определение тональности отзывов или классификация новостных статей.

- Обнаружение аномалий: SVM может быть использован для обнаружения аномального поведения в данных. Например, он может быть применен для обнаружения мошеннических операций на банковских счетах.

Это лишь некоторые примеры использования SVM. Благодаря своей гибкости и высокой производительности, алгоритм SVM продолжает активно применяться в различных областях науки и техники.