Байт (от англ. byte) – одна из основных единиц информации в компьютинге и цифровых устройствах. Байт является минимальной адресуемой единицей памяти, которая используется для хранения и передачи данных. Все данные, которые обрабатываются компьютером, представлены в виде последовательности байтов.

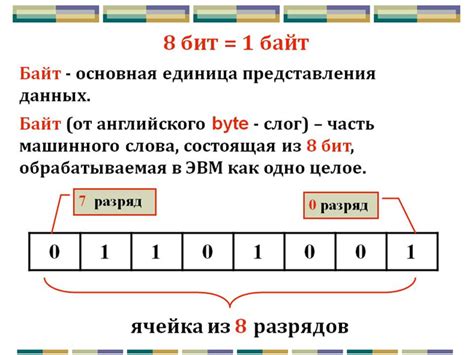

В информатике байт обычно состоит из 8 битов (от англ. bit) – наименьших единиц информации, которые могут принимать значения 0 или 1. В одном байте может быть записано 256 различных значений. Это достаточно для представления букв, цифр, специальных символов и других символов текста, а также чисел, звуков и изображений.

Байт важен для понимания работы компьютеров и программирования. Знание понятия байта позволяет разбираться в структуре и формате данных, а также эффективно использовать ресурсы компьютера, оптимизировать объемы передаваемой информации и повышать эффективность работы программ.

Термин "байтить" или "байт" также используется в сфере социальных медиа для обозначения активности пользователей, заключающейся в лайках, комментариях или репостах. Массовый лайкинг или комментирование могут быть обозначены как "байтить" или "взял байт". Это выражение стало популярным благодаря социальным сетям и стилю жизни, связанному с постоянным комментированием и оцениванием контента.

Определение понятия "байт"

Одним байтом можно представить 256 различных значений, так как каждый из 8 битов может иметь два возможных состояния – 0 или 1. Это позволяет использовать байты для представления широкого спектра информации, включая текст, аудио, видео, изображения и многое другое.

В компьютерных системах часто используется двоичная система счисления, где двоичные числа представлены с помощью байтов. Например, каждый символ в кодировке ASCII занимает один байт. Это позволяет компьютерам обрабатывать текстовую информацию с использованием двоичного кода и выполнять операции над ней.

Объем информации, измеряемый в байтах, часто используется для описания размера файлов, объема памяти компьютера или сетевой пропускной способности. Более крупные единицы измерения информации, такие как килобайт, мегабайт и гигабайт, используют множители для представления больших объемов данных.

Важно отметить, что байты широко применяются в компьютерной науке и информационных технологиях для работы с данными. Понимание понятия "байт" является важным для понимания основ компьютерной архитектуры и программирования.

Размер и структура байта

Бит - это базовая единица информации, которая может принимать два значения: 0 или 1. Байт состоит из 8 бит, что позволяет представить 256 различных значений (2 в степени 8).

Структура байта определяет способ, в котором биты организованы для представления информации. Стандартная структура байта включает 7 бит для представления символов и 1 бит для контроля четности.

Младший бит (LSB) - это самый правый бит в байте, который имеет меньшую весовую значимость. Старший бит (MSB) - это самый левый бит, который имеет большую весовую значимость.

Размер байта может быть разным в разных компьютерных системах. В настоящее время наиболее распространенным размером байта является 8 бит. Однако существуют и другие размеры байта, такие как 6, 7, 9 и 10 бит.

История возникновения понятия "байт"

В середине 20 века, когда только начинался период развития вычислительной техники, сложилась необходимость унификации понятий и стандартов для обмена информацией между различными компьютерами и устройствами.

В 1956 году американский ученый Уэсли Клауд Эйри сформулировал понятие "байт" и предложил его использование в рамках единой системы измерений информации. Термин "байт" произошел от английского слова "bite", которое в переводе означает "укус".

В то время, размерность байта была очень важна, поскольку компьютеры стали использовать двоичное кодирование информации, представляя символы и числа комбинацией из восьми бит.

Со временем, стандартный размер байта, равный 8 битам, стал принятым во всей компьютерной индустрии. Он был основой для различных стандартов и протоколов передачи данных.

Таким образом, история возникновения понятия "байт" связана с появлением необходимости в унификации измерения информации и двоичного представления данных. Он является важным понятием в области компьютерной науки и играет ключевую роль в процессе обмена и обработки информации.

Развитие понятия "байт" в компьютерной технике

Понятие "байт" появилось в компьютерной технике в середине XX века и с тех пор претерпело значительные изменения и развитие. Вначале "байт" был определен как самое маленькое адресуемое значение в памяти компьютера.

Изначально "байт" был равен восьми битам, что позволяло кодировать 256 различных символов. Однако, с развитием технологий и увеличением объемов памяти, данный формат стал недостаточным.

В 1960-х годах был предложен новый стандарт, согласно которому "байт" стал равен 16 битам или двум байтам. Это позволило кодировать гораздо больше символов и улучшило производительность компьютеров. Однако, увеличение размера "байта" привело к несовместимости с уже существующими системами.

В конце 1970-х годов стандарт "байта" был изменен еще раз. Теперь "байт" состоял из 8 бит и стал самым распространенным форматом в компьютерной технике. Работа с данными стала более единообразной и простой.

Однако, несмотря на то, что "байт" официально равен 8 битам, в некоторых системах и архитектурах использовался "байт" размером в 9, 10 или даже 12 битов. Это связано с особенностями реализации аппаратного обеспечения и программного обеспечения компьютеров.

Следует отметить, что с развитием вычислительной техники и введением новых архитектур, понятие "байт" начало утрачивать свою обозначающую роль и стало восприниматься как единица измерения объема информации.

Применение байта в современности

1. Хранение данных: В компьютерных системах информация хранится в виде последовательности байтов. Например, текстовые файлы, изображения, аудио и видео файлы всегда записываются с использованием байтов, где каждый символ или пиксель представляется определенной последовательностью байтов. Байты позволяют эффективно сохранять и передавать разнообразную информацию.

2. Компьютерные сети: При передаче данных через сети байты служат основной единицей передачи. Например, при скачивании или отправке файлов через интернет, информация разбивается на байты и передается по сети. Байты также используются для организации сетевых протоколов, таких как TCP/IP.

3. Кодирование и сжатие данных: Байты используются в различных схемах кодирования данных. Например, кодирование текста в ASCII или Unicode представляет каждый символ в виде определенной последовательности байтов. Также байты применяются при сжатии данных, когда информация упаковывается в меньшее количество байтов с помощью специальных алгоритмов сжатия.

4. Криптография: Байты играют важную роль в криптографических алгоритмах и протоколах. Шифрование и дешифрование информации основано на манипуляциях с байтами, включая операции XOR, сдвиги, подстановки и т. д. Байты используются для представления ключей шифрования, хэш-сумм и цифровых подписей.

5. Программирование: В программировании байты используются для работы с данными различных типов. К примеру, в языке C и его производных байты могут быть использованы для работы с двоичными данными и низкоуровневыми структурами данных. Байты также используются для работы с файлами и вводом-выводом данных.

Таким образом, байты играют важную роль в современных информационных технологиях и являются основной единицей для хранения, передачи и обработки данных различных типов и форматов.